Перевірка фактів від DW: Як розпізнати новини, створені ШІ

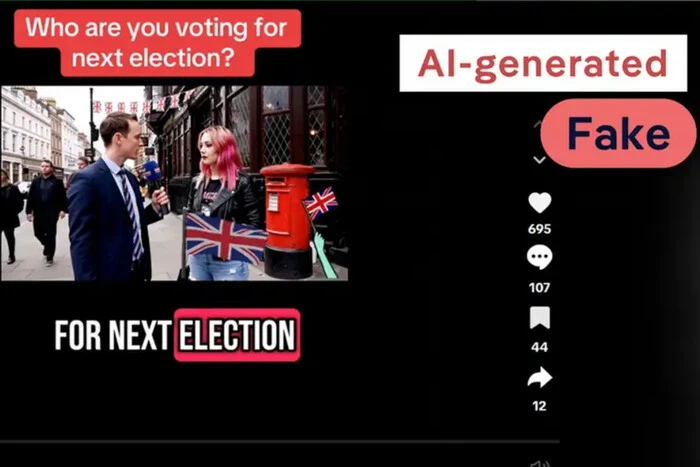

У відеоролику, розміщеному в соціальній мережі TikTok, репортер стоїть перед червоною поштовою скринькою, на задньому плані майорять британські прапори, в руці в нього мікрофон. Він запитає перехожу, за кого вона збирається голосувати на прийдешніх виборах. «За реформи, – відповідає жінка. – Я просто хочу знову відчути себе британкою». Один із користувачів коментує нижче: «Цікаво, скільки їй заплатили за ці слова?».

Але цієї сцени ніколи не було. Інтерв'ю – повна підробка. Репортера не існує в природі – його створив штучний інтелект. І якщо придивитися, можна помітити підказку: ледь помітний водяний знак у кутку зі словом Veo – підпис нового потужного інструменту для генерації відео від Google DeepMind.

Це відео – не поодинокий випадок. Соціальні мережі від TikTok до Telegram заповнені такими випусками «новин» – відео, створеними штучним інтелектом, що імітують зовнішній вигляд та атмосферу реальних новинних сюжетів. Вони запозичують візуальну мову журналістики: репортажі з місця подій, екранну графіку, авторитетне подання. Але вони повністю сфабриковані, часто призначені для того, щоб викликати обурення, маніпулювати думкою чи стати «вірусними».

«Якщо ви швидко прокручуєте стрічку в соціальних мережах, це виглядає як новина, звучить як новина, і в цьому небезпека», – каже експерт із цифрової криміналістики та професор Каліфорнійського університету у Берклі Хані Фарід.

Реальна небезпека «синтетичних» новин

Багато штучно створених відеороликів стирають грань між сатирою та реальністю або просто вводять в оману. В одному з прикладів журналістка, мабуть, описує «величезну військову колону», що рухається центром Лондона. Вона стоїть перед танком, а натовп спостерігає за тим, що відбувається. При цьому відео не згадує жодної конкретної події, часу чи контексту.

Команда перевірки фактів DW неодноразово спостерігала, як подібні кліпи спливають під час криз, наприклад, заворушень, або великих подій, і використовуються для того, щоб створити плутанину або хибно натякнути на різку ескалацію.

Під час останньої ескалації конфлікту між Ізраїлем та Іраном TikTok та інші платформи були переповнені контентом, створеним штучним інтелектом. У відеороликах були фальшиві випуски новин з помилковими твердженнями, наприклад, про вступ Росії у війну, про атаку Ірану на США або про те, що Іран збив американські бомбардувальники B-2, які використовувалися для ударів по іранських ядерних об'єктах. DW також відзначила сплеск кількості створених ШІ роликів новин у червні після початку протестів у Лос-Анджелесі.

Наслідки виходять далеко за межі соціальних мереж. У 2024 році тайванські дослідники виявили на місцевих платформах створені ШІ випуски новин, в яких помилково звинувачували в корупції політиків, що виступають за суверенітет острова. Ці ролики не просто поширювали дезінформацію – вони сіяли недовіру, підриваючи авторитет усіх агентств новин напередодні виборів у країні.

Однак деякі користувачі дивляться згенеровані ШІ випуски новин заради пародії або комічного ефекту. В одному з вірусних роликів TikTok показаний згенерований ШІ ведучий новин на тлі такої глибокої вибоїни на дорозі, що в ній зникають мотоцикли. В іншому ролику аватар заявляє: «Я зараз на кордоні, але війни немає. Мама, тато, це виглядає реалістично, але це все ШІ».

Отже, як відрізнити справжнє відео від підробки? Почніть із водяних знаків. Такі сервіси, як Veo, Synthesia та інші часто маркують свої відео, хоча ці мітки іноді розмиті, обрізані або ігноруються. Навіть чітко позначені кліпи часто рясніють коментарями з питанням: «Це справжнє?».

Як відрізнити фейкові випуски новин

Фальшиві випуски новин – один з найретельніше опрацьованих матеріалів, створених ШІ. Оскільки вони часто зображують статичну обстановку студій новин, складніше помітити типові ознаки роботи ШІ – такі, як незграбні рухи рук або нестабільне тло. Але ледь помітні підказки все ж таки залишаються.

Стежте за очима та ротом. Штучні аватари часто неприродно моргають або мають труднощі з реалістичною синхронізацією губ. Зуби можуть виглядати надто гладкими або неприродно блискучими. Їхня форма може навіть змінюватися посередині речення. Жести та міміка, як правило, надто одноманітні, позбавлені природної варіативності, властивої справжнім людям.

Текст може бути самовикриттям фейку. Екранні субтитри або банери часто містять безглузді фрази або друкарські помилки.

За словами Хані Фаріда, виявлення згенерованого ШІ контенту – «складне завдання» як ураження цілі, що рухається: «Все, що я вам сьогодні розповім про те, як виявити фейки ШІ, може виявитися неактуальним через пів року». То що робити? Дотримуватись перевірених джерел. «Якщо не хочете, щоб вас обманювали, користуйтеся надійними ЗМІ», – радить Фарід.

Зникли бар'єри для виробництва медіа-контенту

Концепція ШІ-ведучих не нова. У 2018 році китайське державне інформаційне агентство «Сіньхуа» представило досить примітивного аватара-ведучого, створеного ШІ. На той час це виглядало радше потішно, ніж загрозливо.

Але технології значно еволюціонували. Такі інструменти, як Veo, тепер дозволяють практично будь-якій людині без медіа-підготовки створювати відшліфовані відеоролики у стилі прямої трансляції лише за кілька сотень євро на місяць. Ведучі в такому відео говорять плавно, рухаються реалістично і можуть бути поміщені практично в будь-яку сцену за допомогою кількох команд, заданих за допомогою клавіатури.

«Бар'єр для входу (у виробництво медіа-контенту. – ред.) практично зник. Вам не потрібна студія. Вам навіть не потрібні факти», – каже Фарід. Більшість цих кліпів створено для максимального залучення користувачів. Вони торкаються дуже спірних тем – міграція, війна в Секторі Гази, Україна, Дональд Трамп – щоб викликати сильні емоційні реакції та спонукати до подальшого поширення цих відео.

Соціальні мережі часто свідомо просувають такий контент. Наприклад, Meta нещодавно скоригувала свій алгоритм, щоб показувати більше дописів з облікових записів, на які користувачі не підписані, що полегшує охоплення створених ШІ відео широкою аудиторією, яка нічого не підозрює. Програми монетизації додатково стимулюють творців: щобільше переглядів набирає відео, тим більше грошей воно може принести.

Зробити легкі гроші на «штучному мотлоху»

Це середовище породило нове покоління творців «штучного мотлоху» – користувачів, які штампують низькоякісний ШІ-контент, прив'язаний до трендових тем просто, щоб набрати перегляди.

Ці облікові записи часто публікують термінові новини, перш ніж журналісти встигають підтвердити факти. Під час нещодавньої авіакатастрофи в Індії десятки відеороликів у TikTok були представлені ШІ-аватарами, стилізованими під репортерів CNN або BBC, які транслювали фальшиві цифри жертв та сфабриковані свідчення очевидців. Багато з них лишалося в мережі годинами, перш ніж їх видаляли.

У моменти виходу термінових новин, коли користувачі активно шукають інформацію, реалістичний ШІ-контент стає особливо ефективним способом отримати велику кількість переглядів та заробити на громадській увазі.

«Платформи послабили модерацію контенту. Це «ідеальний шторм»: я можу створювати контент, можу його поширювати, і є аудиторія, яка готова вірити», – зазначає Фарід.

Монір Ґаеді